만약 우리가 SMR이나 차세대 에너지원으로 100GW의 막대한 전력을 확보했다고 가정해 봅시다. 그 전기는 ‘어디로’ 가야 할까요? AI의 ‘뇌'(LLM)와 ‘심장'(전력)이 준비되었다면, 이제는 그 뇌가 실제로 거주하고 일할 수 있는 ‘신경 중추 기지’, 즉 ‘AI 데이터센터(AI Datacenter)’가 필요합니다.

최근 OpenAI의 샘 알트만이 MS와 함께 1,000억 달러(약 130조 원) 규모의 슈퍼컴퓨터 프로젝트 ‘스타게이트(Stargate)’를 추진 중이라는 뉴스가 세상을 놀라게 했습니다. 이 프로젝트는 ‘AI 데이터센터’가 더 이상 우리가 알던 ‘서버실’ 수준이 아님을 보여줍니다.

이번 글에서는 데이터센터가 무엇이며, 왜 AI 시대에 ‘혁신의 엔진’인 동시에 ‘최대의 병목’이 되고 있는지, 그리고 이 거대한 ‘AI 공장’을 구성하는 핵심 기술과 장비는 무엇인지 집중적으로 분석합니다.

1. 데이터센터란 무엇인가?: ‘인터넷 창고’에서 ‘AI 공장’으로의 진화

데이터센터(Datacenter)는 간단히 말해 ‘디지털 세계의 모든 데이터와 연산이 일어나는 물리적인 건물’입니다. 우리가 유튜브를 보고, 이메일을 보내고, 클라우드에 사진을 저장하는 모든 행위는 지구 반대편 어딘가에 있는 데이터센터 서버의 ‘연산’을 통해 이루어집니다.

하지만 우리가 지금 주목해야 할 것은, ‘AI 시대’의 데이터센터는 ‘과거의 데이터센터’와 근본적으로 다르다는 점입니다.

- 과거 (Web 2.0 / 클라우드 시대):

- 목적: 데이터 ‘저장’ 및 ‘전달’ (예: 넷플릭스 영상 스트리밍, 웹사이트 호스팅)

- 핵심 부품: CPU (중앙 처리 장치)

- 구조: 수평적(Scale-out). 수많은 저전력 서버가 작업을 ‘나눠서’ 처리.

- 비유: 거대한 ‘디지털 도서관’ 또는 ‘물류 창고’.

- 현재 (AI 시대):

- 목적: AI 모델의 ‘학습(Training)’ 및 ‘추론(Inference)’

- 핵심 부품: GPU (그래픽 처리 장치), TPU 등 AI 가속기

- 구조: 수직적(Scale-up). 초고전력 GPU 수만 개가 ‘하나의 클러스터’처럼 동시에 병렬 연산.

- 비유: 24시간 최대치로 가동되는 ‘AI 두뇌 공장’.

이 ‘목적’과 ‘구조’의 변화가 바로 AI 데이터센터가 새로운 병목이 된 이유입니다.

2. 왜 AI 데이터센터는 ‘병목(Bottleneck)’이 되었는가?

샘 알트만의 ‘스타게이트’가 1,000억 달러라는 천문학적인 비용과 수 GW(기가와트)라는, 원전 5~7기 분량의 전력을 요구하는 이유는 무엇일까요? 이는 AI 데이터센터가 기존의 상식으로는 해결할 수 없는 네 가지 극한의 ‘물리적 한계’에 봉착했기 때문입니다.

1) 병목 1: 전력 밀도 (Power Density) – ‘끓어오르는 랙’

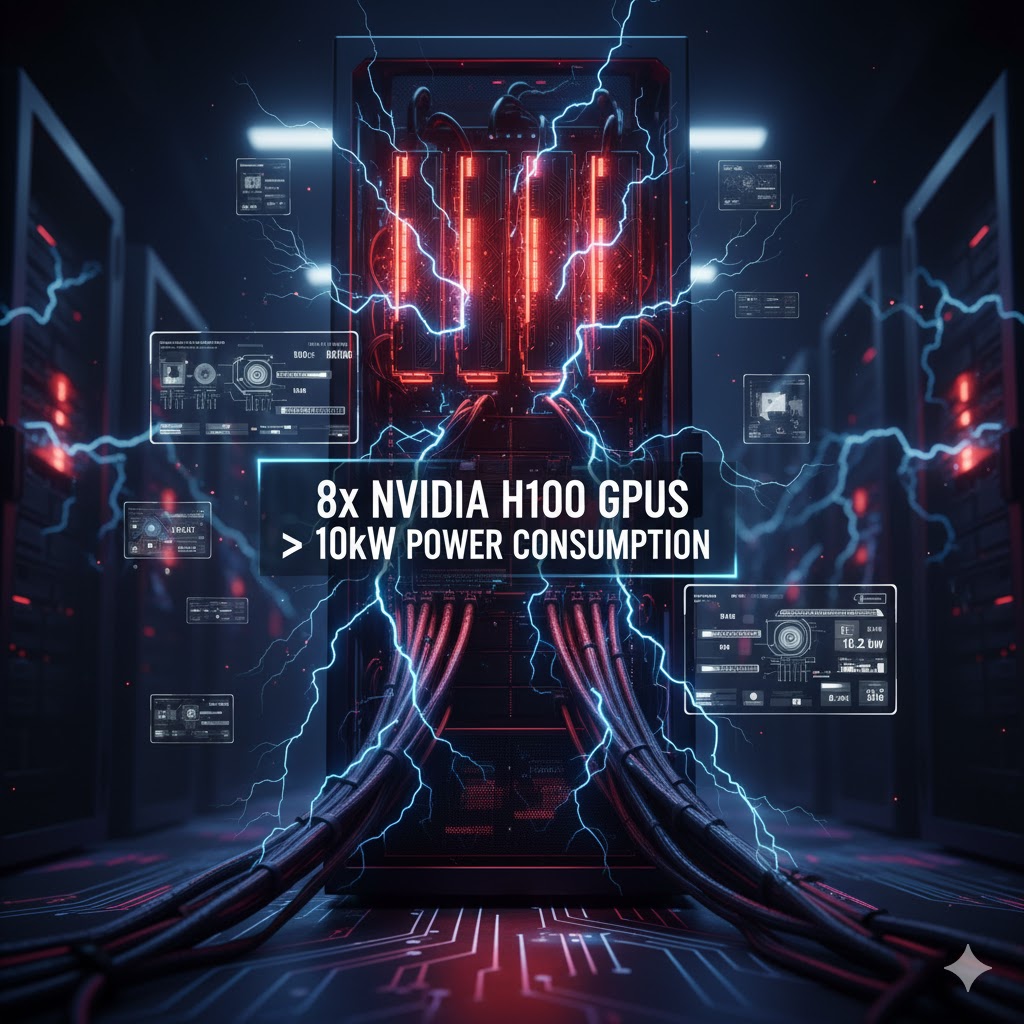

가장 심각한 문제입니다. 과거 CPU 기반 서버는 1개의 랙(Rack, 서버를 꽂는 캐비닛)당 5~10kW의 전력을 소비했습니다. 하지만 엔비디아 H100 GPU 8개가 꽂힌 서버 1대의 전력 소모가 10kW를 넘습니다. 이런 서버가 랙 하나에 4~8대씩 꽂히면, 랙 1개당 전력 소모가 50kW, 100kW, 심지어 150kW까지 치솟습니다.

- 문제점: 랙 1개에서 소형 아파트 30~50가구가 쓰는 전기를 동시에 끌어다 쓰는 셈입니다. 기존 데이터센터는 이런 ‘전력 밀도’를 감당하도록 설계되지 않았습니다. 변압기, 배전반, 케이블 등 건물 전체의 전력 인프라가 이 열(熱)을 견딜 수 없습니다.

2) 병목 2: 냉각 (Cooling) – ‘공기로는 끌 수 없는 불’

전력 소모는 100% ‘열’로 변환됩니다. 100kW의 열을 뿜어내는 랙을 기존의 ‘공기 냉각(Air Cooling)’ 방식(찬 바람을 불어넣는 방식)으로는 절대 식힐 수 없습니다.

- 문제점: GPU가 과열되면 즉시 성능이 저하(Throttling)되거나 타버립니다. AI 연산은 100% 성능으로 24시간 가동되어야 하므로, 냉각이 실패하면 AI 공장 전체가 멈춥니다.

- 해결책: 이 때문에 ‘액체 냉각(Liquid Cooling)’이 유일한 대안으로 떠올랐습니다. (이는 뒤에 핵심 기술에서 자세히 다룹니다.)

3) 병목 3: 네트워킹 (Networking) – ‘GPU간의 고속도로 정체’

AI 학습(Training)은 수만 개의 GPU가 마치 ‘하나의 거대한 뇌’처럼 동시에 데이터를 주고받아야 합니다. 이 ‘GPU 클러스터 내부 통신(East-West Traffic)’ 속도가 AI 성능을 좌우합니다.

- 문제점: 우리가 ‘인터넷 속도'(North-South Traffic)라고 부르는 것과는 차원이 다른, 초고대역폭, 초저지연(Low-Latency) 통신이 필요합니다. 이 GPU간 고속도로가 막히면, 수조 원짜리 GPU들은 아무리 많아도 ‘데이터를 기다리며’ 놀게 됩니다.

- 해결책: 엔비디아의 ‘인피니밴드(InfiniBand)’나 초고속 ‘이더넷(Ethernet)’ 같은 특수 네트워킹 기술이 필요합니다.

4) 병목 4: 물리적 공급망 (Physical Supply Chain)

AI 데이터센터는 AI 반도체(GPU)만 있다고 지을 수 없습니다. 이 모든 것을 연결하는 **’기반 설비’**의 공급이 AI의 속도를 따라잡지 못하고 있습니다.

- 문제점: 샘 알트만과 일론 머스크가 공통적으로 지적하는 ‘진짜’ 병목은 변압기(Transformers)입니다. SMR이 전기를 만들어도, 그 전기를 데이터센터가 쓸 수 있는 전압으로 바꿔주는 거대 변압기의 생산 리드타임이 2년 이상 걸립니다.

- 기타: 발전기, 무정전 전원 장치(UPS), 광케이블, 심지어 건물을 지을 토지와 물(액체 냉각용)까지 모든 것이 제약 조건입니다.

3. ‘AI 공장’을 짓는 핵심 기술과 장비

이 4가지 극한의 ‘병목 현상’을 해결하기 위해, 데이터센터 산업은 지난 30년간의 기술을 버리고 완전히 새로운 ‘엔지니어링 혁명’을 맞이하고 있습니다.

1) 핵심 기술 1: 냉각 (Cooling) – “공기에서 액체로”

‘100kW 랙’이라는 전력 밀도(병목 1)는 ‘공랭식(Air Cooling)’의 종말을 의미합니다. 100kW의 열을 선풍기(팬)로 식힐 수 없기 때문입니다. 이를 해결하기 위한 유일한 대안이 바로 ‘액체 냉각(Liquid Cooling)’입니다.

- 다이렉트 투 칩 (Direct-to-Chip, D2C) 냉각:

- 가장 뜨거운 부품(GPU, CPU) 위에 물이나 특수 냉각수가 흐르는 ‘워터블럭(Water Block)’을 직접 부착하는 방식입니다.

- 자동차의 ‘라디에이터’와 원리가 같습니다. 냉각수가 칩의 열을 흡수해 건물 밖의 냉각탑(Chiller)으로 보냅니다.

- 현재 AI 데이터센터의 ‘주류’ 기술로 가장 빠르게 도입되고 있습니다.

- 액침 냉각 (Immersion Cooling):

- 가장 궁극적인 냉각 방식입니다. 아예 서버 전체를 전기가 통하지 않는 특수 냉각 용액(기름처럼 생김)에 통째로 담가버리는 방식입니다.

- 단상(Single-Phase): 냉각액이 끓지 않고 순환하며 열을 식힙니다.

- 이상(Two-Phase): 냉각액이 GPU의 열에 닿아 ‘기화(끓음)’하고, 이 기체가 다시 ‘액화’되는 과정에서 열을 방출합니다. 가장 효율이 높지만 가장 비쌉니다.

- 액침 냉각은 ‘스타게이트’ 같은 차세대 ‘초고밀도’ 데이터센터의 필수 기술로 꼽힙니다.

2) 핵심 기술 2: 네트워킹 (Networking) – “GPU간 초고속 도로”

AI 학습은 수만 개의 GPU가 하나의 뇌처럼 움직여야 합니다(병목 3). 이를 위해 ‘인터넷 속도’와는 비교도 안 되는 초고속 내부 통신망이 필요합니다.

- 인피니밴드 (InfiniBand):

- 엔비디아(NVIDIA)가 주도하는 기술입니다. 엔비디아는 GPU(H100)뿐만 아니라, 이 GPU들을 최고 속도로 연결하는 ‘NVLink’ 스위치와 ‘인피니밴드’ 네트워킹 카드(ConnectX)를 패키지로 팝니다.

- 초저지연, 초고대역폭을 제공하여 GPU 클러스터 성능을 극대화합니다. 엔비디아 ‘DGX SuperPOD’의 핵심입니다.

- 초고속 이더넷 (Ethernet) – (RoCE):

- 엔비디아의 ‘인피니밴드’ 독점에 대항하는 ‘개방형 표준’ 기술입니다.

- Arista Networks(ANET), Broadcom(AVGO), Cisco(CSCO) 등이 주도하며, ‘이더넷’ 기술을 기반으로 인피니밴드와 유사한 초고속/초저지연 성능을 구현합니다.

- MS, 구글, 메타 등 빅테크 기업들은 특정 기업(엔비디아)에 종속되는 것을 피하기 위해 이 ‘이더넷’ 방식을 강력하게 밀고 있습니다.

3) 핵심 기술 3: 전력 인프라 (Power Infrastructure)

AI 데이터센터는 AI 반도체만큼이나 ‘변압기’와 ‘배전반’이 중요합니다(병목 4).

- 변압기 (Transformers): SMR 원전이 만든 초고압 전기를 데이터센터가 쓸 수 있는 전압으로 바꿔주는 핵심 장비입니다. AI 수요 폭증으로 ‘공급 리드타임이 2년’에 달하는, 현재 가장 심각한 물리적 병목입니다.

- 고밀도 랙 PDU & 버스바 (Busbar):

- 기존의 전선(Cable)으로는 100kW 랙에 전기를 공급하다가 녹아버릴 수 있습니다.

- 이를 해결하기 위해 공항이나 공장에서 쓰던 거대한 구리 막대기 형태의 ‘버스바(Busbar)’를 데이터센터 천장이나 바닥에 설치하여, 케이블 없이 랙에 직접 대용량 전기를 공급합니다.

4. 결론: ‘스타게이트’가 말하는 것, “데이터센터가 곧 AI의 한계다”

AI 혁명은 더 이상 코드나 알고리즘만의 싸움이 아닙니다. 이는 ‘전력’, ‘냉각’, ‘네트워킹’, ‘물리적 공간’을 확보하기 위한 거대한 ‘인프라 전쟁’입니다.

샘 알트만의 ‘스타게이트(Stargate)’ 프로젝트는 “미래의 AI 성능은 얼마나 강력한 AI 데이터센터를 지을 수 있느냐에 달려있다”는 것을 선언한 것입니다. 1,000억 달러라는 비용은 단순히 GPU를 사는 값이 아니라, 이 모든 ‘병목 현상'(전력, 냉각, 네트워킹, 변압기, 건물)을 한 번에 해결하기 위한 ‘물리적 인프라’ 구축 비용입니다.

AI의 ‘뇌'(GPU)를 만드는 엔비디아(NVIDIA)가 지난 2년간 시장을 지배했다면, 이제 시장의 관심은 그 뇌가 살아갈 ‘몸통’과 ‘신경망’, 즉 데이터센터 인프라(액체 냉각, 네트워킹, 전력 설비)를 만드는 기업들로 빠르게 옮겨가고 있습니다.

다음 글에서는 이 ‘AI 공장’을 짓는 핵심 기업들은 누구인지 본격적으로 파헤쳐 보겠습니다.